Einführung

Proxmox unterstützt verschiedene Speicherarten für VM-Images und Container. Nach einer SDR-Installation finden Sie eine für diesen Zweck vorbereitete Festplatte mit LVM. Wenn Sie Speicher für ein HA-Szenario benötigen, sollten Sie Ceph (in Multi-Node-Clustern) oder ZFS (insbesondere in Zwei-Node-Clustern) nutzen.

Doch bevor Sie solche Speicher auf den ungenutzten Festplatten erstellen können, müssen alle Daten gelöscht werden.

Vorbereitungen

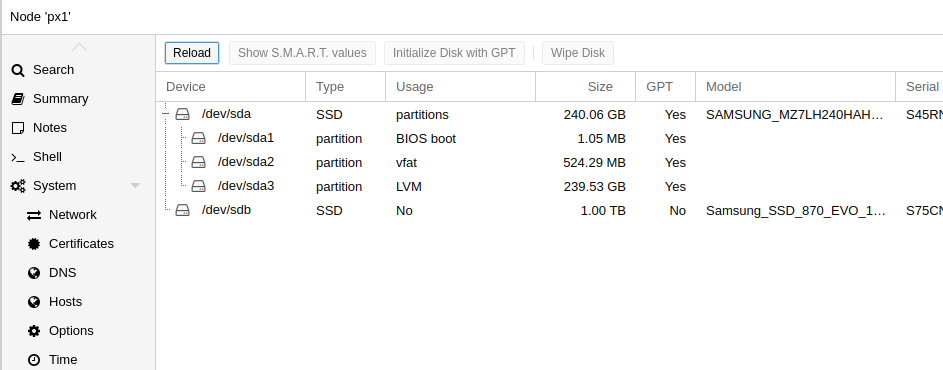

Um ungenutzte Festplatten zu prüfen, melden Sie sich in der Proxmox-WebUI an und wählen einen Node. Klicken Sie dann im Node-Menü auf den Eintrag Disks. Mindestens eine Festplatte muss in der Tabelle der Node-Festplatten den Status No in der Spalte Usage aufweisen. Ist dies nicht der Fall, können genutzte Festplatten freigegeben werden.

Ungenutzte Festplatten müssen mit GPT1 initialisiert werden. Wählen Sie dazu die Zeile der Festplatte aus und klicken Sie über der Tabelle auf Initialize Disk with GPT. Nach wenigen Sekunden ist die Festplatte initialisiert.

Schlägt die Initialisierung fehl, kann der Befehl /sbin/sgdisk /dev/sdX -Z in der Kommandozeile helfen.

Entfernen von Festplatten aus LVM

Wenn Sie Ceph oder ZFS verwenden, werden LVM-Speicher auf einem Node oft nicht mehr benötigt. Dafür müssen die Festplatten aus LVM entfernt werden. Derzeit ist dies nur über die Kommandozeile möglich.

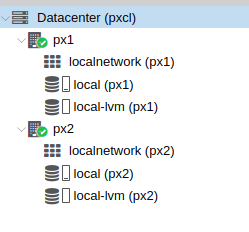

Zuerst identifizieren Sie die Festplatten, die entfernt werden sollen. In der Proxmox-WebUI sehen Sie die Storages der Nodes.

Öffnen Sie dann im Node-Menü Disks/LVM. Dort werden alle VGs (Volume Groups) mit ihren PVs (Physical Volumes) angezeigt. Bestehende LVM-Thin-LVs (Logical Volumes) sind unter Disks/LVM-Thin gelistet. Auf einem frisch installierten System gibt es in der Regel drei LVs: data (Thin), root und swap. Die LVs root und swap werden in der WebUI nicht angezeigt, sind aber für das System notwendig.

Es gibt zwei mögliche Situationen:

- Das LV data liegt auf einem eigenen PV (z. B. pvevm) und nutzt die ganze Festplatte. Dann siehe Volume Group von Festplatte entfernen.

- Das LV data ist Teil eines anderen PV (z. B. pve). Dann siehe Festplatte aus Volume Group entfernen.

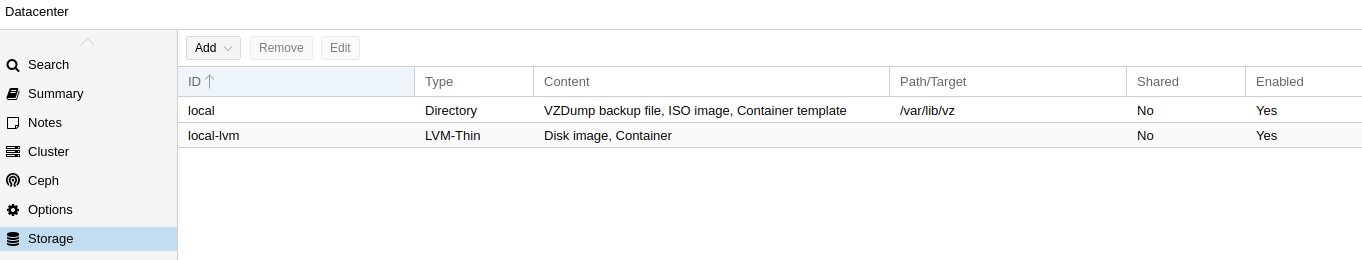

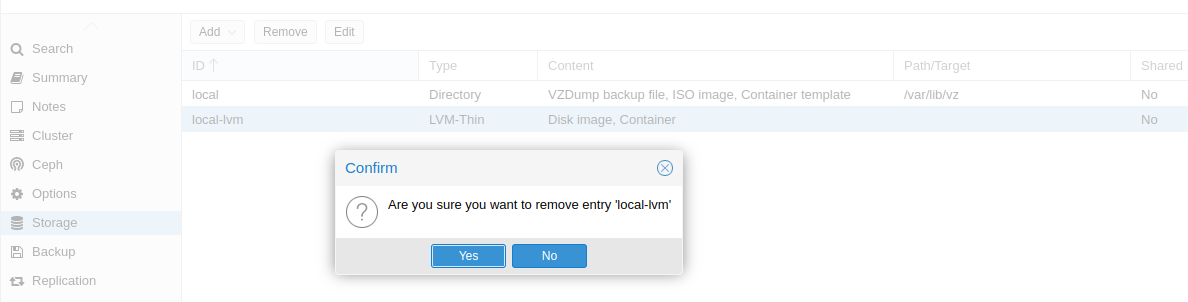

Wenn data komplett von allen Nodes entfernt werden soll, löschen Sie zuerst das Storage local-lvm im Datacenter.

Öffnen Sie dazu das Storage-Menü im Datacenter, wählen das Storage aus und entfernen es über Remove.

Nun wechseln Sie zur Kommandozeile. Dort können Sie alle LVM-Befehle verwenden. Die Änderungen werden von der WebUI automatisch erkannt.

Volume Group von Festplatte entfernen

Dieses Beispiel zeigt, wie Sie eine Volume Group und alle enthaltenen Logical Volumes löschen, wenn die VG die gesamte Festplatte belegt.

PVs prüfen:

root@tc3:~# pvs

PV VG Fmt Attr PSize PFree

/dev/sda3 pve lvm2 a-- <223.08g <165.08g

/dev/sdb1 pvevm lvm2 a-- <930.54gg 0

Hier nutzt die VG pvevm die gesamte Festplatte /dev/sdb. Um sie zu entfernen, muss die VG deaktiviert werden:

root@tc3:~# vgchange -a n pvevm

0 logical volume(s) in volume group "pvevm" now active

Anschließend können Sie die VG und alle enthaltenen LVs löschen:

root@tc3:~# vgremove -f pvevm

Logical volume "data" successfully removed.

Volume group "pvevm" successfully removed

Entfernen Sie dann die LVM-Labels von der Festplatte:

root@tc3:~# pvremove /dev/sdb1

Labels on physical volume "/dev/sdb1" successfully wiped.

Festplatte bereinigen:

root@tc3:~# wipefs -a -f /dev/sdb

/dev/sdb: 8 bytes were erased at offset 0x00000200 (gpt): 45 46 49 20 50 41 52 54

/dev/sdb: 8 bytes were erased at offset 0xe8e0db5e00 (gpt): 45 46 49 20 50 41 52 54

/dev/sdb: 2 bytes were erased at offset 0x000001fe (PMBR): 55 aa

Festplatte aus Volume Group entfernen

Dieses Beispiel zeigt, wie Sie das LV data verkleinern und anschließend ein PV aus einer VG mit zwei PVs entfernen. In Landitec GmbH-Appliances ist die Situation meist einfacher.

LVs und PVs prüfen:

root@tc3:~# lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

data pve twi-aotz-- 186.57g 0.00 10.42

root pve -wi-ao---- 27.00g

swap pve -wi-ao---- 8.00g

root@tc3:~# pvs

PV VG Fmt Attr PSize PFree

/dev/sda3 pve lvm2 a-- 109.97g 0

/dev/sdb1 pve lvm2 a-- 111.79g 0

Das LV data muss auf 70 GB verkleinert werden, damit alle LVs auf /dev/sda3 passen. Anschließend kann das PV /dev/sdb1 aus der VG pve entfernt werden. Da ein Thin-LVM derzeit nicht nachträglich vergrößert werden kann, muss es neu erstellt werden.

Achtung: Alle Daten auf diesem Thin-LVM werden dabei gelöscht!

root@tc3:~# lvremove pve/data

Do you really want to remove and DISCARD active logical volume pve/data? [y/n]: y

Logical volume "data" successfully removed

root@tc3:~# lvcreate -T -L 70G pve/data

Using default stripesize 64.00 KiB.

Logical volume "data" created.

root@tc3:~# lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

data pve twi-a-tz-- 70.00g 0.00 10.43

root pve -wi-ao---- 27.00g

swap pve -wi-ao---- 8.00g

Verschieben Sie nun alle Daten von /dev/sdb1 nach /dev/sda3, um Datenverlust zu vermeiden. Anschließend können Sie das PV /dev/sdb1 aus der VG pve streichen und die LVM-Signaturen entfernen:

root@tc3:~# pvmove /dev/sdb1

/dev/sdb1: Moved: 5.56%

/dev/sdb1: Moved: 100.00%

root@tc3:~# pvs

PV VG Fmt Attr PSize PFree

/dev/sda3 pve lvm2 a-- 109.97g 4.83g

/dev/sdb1 pve lvm2 a-- 111.79g 111.79g

root@tc3:~# vgreduce pve /dev/sdb1

Removed "/dev/sdb1" from volume group "pve"

root@tc3:~# pvremove /dev/sdb1

Labels on physical volume "/dev/sdb1" successfully wiped.

root@tc3:~# pvs

PV VG Fmt Attr PSize PFree

/dev/sda3 pve lvm2 a-- 109.97g 4.83g

Festplatte löschen

Als letzter Schritt, bevor die Festplatte für Ceph oder ZFS verwendet werden kann, sollte sie gelöscht werden. Öffnen Sie dazu in der WebUI das Menü Disks des Nodes. Wählen Sie die Festplatte aus und klicken Sie über der Tabelle auf Wipe Disk.

Nun ist die Festplatte bereit für Ceph, ZFS oder LVM.