Clusterbeschreibung

Ein Cluster besteht aus zwei oder mehr Nodes, die miteinander kommunizieren. Ein Proxmox-Cluster ermöglicht die Verwaltung über eine einzige WebUI, die auf jedem Node im Cluster aufgerufen werden kann.

Falls Sie an Hochverfügbarkeit interessiert sind, sollte die Anzahl der Nodes ungerade sein (3, 5, …), um bei einer Netzwerktrennung im Cluster Probleme zu vermeiden.

Bevor Sie beginnen, einen Proxmox-Cluster zu erstellen, sollten alle Nodes auf die neueste Softwareversion aktualisiert werden.

Die auf den Nodes installierte Proxmox-Version sollte auf allen Nodes identisch sein. Bitte konsultieren Sie die Proxmox-Dokumentation, um alle Nodes eines Clusters zu aktualisieren.

Node

Landitec GmbH-Appliances, die mit Proxmox vorinstalliert sind, sind in verschiedenen Modellen erhältlich. Die folgende Tabelle listet die Appliances mit einigen Hardware-Details auf.

| Model | OS disk | LVM disk | unused disks | Network |

|---|---|---|---|---|

| scope7-5030-Proxmox-M | 1 | 1 | 6 | |

| scope7-5030-Proxmox-L | 1 | 1 | 1 | 6 |

Das Betriebssystem ist auf einer Festplatte installiert und die nächste Festplatte wird als Storage für VM-Images (LVM) verwendet. Alle anderen verfügbaren Festplatten werden standardmäßig nicht genutzt und können für eigene, individuelle Storage-Konfigurationen (z. B. Ceph) verwendet werden.

Es ist nicht erforderlich, in einem Cluster dieselben -Appliance-Modelle zu verwenden. Je nach Anforderung können verschiedene Modelle gemischt werden, jedoch sollte die Proxmox-Softwareversion auf allen Nodes gleich sein.

Abgesehen von der identischen Softwareversion sollten alle Nodes auch die gleiche Uhrzeit haben. Daher wird empfohlen, die Zeit über NTP zu synchronisieren.

Netzwerk

Jeder Node muss mit demselben Netzwerk verbunden sein, über das die Proxmox WebUI erreichbar ist. Eine zusätzliche Verbindung zu einem anderen Netzwerk für die dedizierte Cluster-Kommunikation wird empfohlen.

In einem späteren Abschnitt dieses Leitfadens wird dieses Netzwerk für Ceph verwendet, das mindestens ein 10-GBit-Netzwerk erfordert. Für die Cluster-Kommunikation genügt ein 100-MBit-Netzwerk.

Das Ändern von Hostname oder IP-Adresse eines Nodes ist nach dem Hinzufügen zum Cluster nicht mehr möglich.

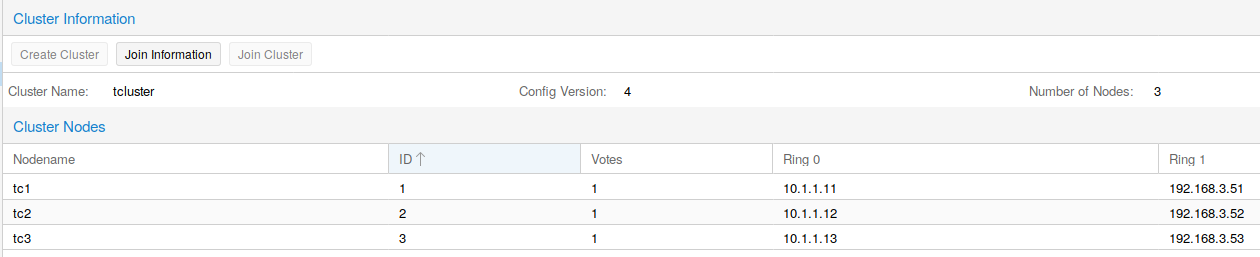

Dies zeigt ein Beispiel für ein Cluster aus drei Nodes, die über zwei Netzwerke verbunden sind. Das Netzwerk MGMT dient der Ansprache der Proxmox WebUI (Management), und das Netzwerk CLST wird für das Cluster und den gemeinsamen Storage verwendet. In diesem Leitfaden werden die Clusternetzwerke wie in der folgenden Tabelle konfiguriert:

| Node | Ring 0 / MGMT | Ring 1 / CLST |

|---|---|---|

| tc1 | 192.168.3.51 | 10.1.1.11 |

| tc2 | 192.168.3.52 | 10.1.1.12 |

| tc3 | 192.168.3.53 | 10.1.1.13 |

Ein Zwei‑Node‑Cluster mit Quorum wird ähnlich aufgebaut; hier wird ein Node durch einen kleinen Server ersetzt. Die einzige Aufgabe dieses Servers besteht darin, dem Cluster eine Stimme hinzuzufügen, damit der Cluster weiterhin VMs ausführen kann, falls ein Node ausfällt.

Cluster aufbauen

Der Aufbau eines Clusters beginnt mit dem Zugriff auf die WebUI. Im Menü Datacenter befindet sich der Menüpunkt Cluster. Hier finden Sie Informationen zu einem bestehenden Cluster oder Schaltflächen zum Erstellen eines neuen Clusters.

Auf dem ersten Node kann ein neues Cluster durch Klicken auf die Schaltfläche Create Cluster erstellt werden. Geben Sie im sich öffnenden Dialog einen Namen für das neue Cluster und eine IP-Adresse ein, falls der Hostname nicht in eine IP-Adresse des Nodes aufgelöst werden kann. Einige Sekunden nach dem Klick auf Create wird ein neues Cluster mit nur einem Node erstellt.

Um einen weiteren Node hinzuzufügen, klicken Sie auf die Schaltfläche Join information und im Dialog auf Copy Information. Die erforderlichen Informationen zum Beitreten eines weiteren Nodes zum Cluster werden in die Zwischenablage kopiert. Optional können Sie den Text im Feld Join Information auch manuell kopieren. Öffnen Sie nun die WebUI des neuen Nodes und gehen Sie zum Menüpunkt Cluster im Datacenter. Öffnen Sie den Join-Dialog durch Klicken auf Join Cluster und fügen Sie die kopierten Daten in das Feld Information ein. Andere Felder werden automatisch ausgefüllt, aber die Felder Password und Corosync Ring 0 müssen vom Benutzer mit passenden Werten ausgefüllt werden. Die Schaltfläche Join startet den Prozess, um den Node dem Cluster hinzuzufügen. Führen Sie dies für alle Nodes durch, die zum Cluster hinzugefügt werden sollen.

Beim Beitritt zum Cluster wird das SSL-Zertifikat der WebUI geändert. Daher müssen Sie die Webseite neu laden, um das neue SSL-Zertifikat für die Verbindung zu übernehmen.

Alle Nodes des Clusters werden nun unter Datacenter aufgelistet, und alle Nodes können von jedem Node im Cluster aus verwaltet werden.

Auch wenn es möglich ist, verschiedene -Appliance-Modelle für den Aufbau eines Clusters zu verwenden, benötigen VMs stets eine einheitliche Sicht auf die Nodes. Andernfalls ist es nicht möglich, VMs von einem Node auf einen anderen zu migrieren. Die wichtigsten Voraussetzungen sind die Netzwerkeinstellungen. Wenn eine VM Zugriff auf die Bridges vmbr0 und vmbr1 benötigt, müssen alle Nodes, zu denen die VM migriert werden kann, diese Netzwerke ebenfalls konfiguriert haben.

Die Migration einer VM von einem Node zu einem anderen erfordert zudem freie Ressourcen für CPU, RAM und Festplatte auf dem Ziel-Node. Ohne gemeinsamen Storage ist nur eine Offline-Migration möglich. Die VM muss gestoppt werden, um sie auf einen anderen Node migrieren zu können.

Wiederherstellen eines Clusternodes

Im Falle eines Node-Ausfalls kann ein Ersatz-Node in wenigen Schritten mithilfe einer Backup-Datei und SDR erstellt werden. Kopieren Sie dazu die Backup-Datei, erstellt mit dem Befehl pxbackup, auf den SDR-USB-Stick (die Datei auf dem Stick muss configuration.dat heißen). Stecken Sie den SDR-Stick in einen USB-Port der Ersatz-Appliance und schalten Sie diese ein. Nach Abschluss des SDR-Vorgangs schalten Sie die Appliance aus und entfernen den SDR-Stick. Schließen Sie alle Netzwerkkabel wie beim Originalgerät an und starten Sie das System. Der Node wird neu gestartet, um die Konfiguration aus der Backup-Datei zu aktivieren, und tritt in Kürze dem bestehenden Cluster bei.

Wenn als Ersatz ein anderes Appliance-Modell verwendet wird, kann sich die Bezeichnung der Netzwerkports unterscheiden. In diesem Fall melden Sie sich mit Monitor und Tastatur an und passen die Netzwerkports in der Datei /etc/network/interfaces an. Starten Sie danach den Node neu.

Sobald der Node wieder dem Cluster beigetreten ist, empfiehlt sich ein Software-Upgrade auf die neueste Version.

Festplatten werden durch den Wiederherstellungsprozess nicht neu konfiguriert. Bitte konfigurieren Sie Ihre Festplatten manuell (z. B. LVMs, ZFS, Ceph-OSDs etc.).